Verhält sich ein selbstfahrendes Auto in einer klassischen Dilemma-Situation anders als es Testpersonen tun würden, ist diese Diskrepanz in den Gehirnaktivitäten sichtbar. Das konnten Forschende des Departments für Psychologie an der Universität Oldenburg jetzt in einer Studie zeigen. Die Erkenntnisse sollen langfristig dazu beitragen, dass Menschen autonom gesteuerte Fahrzeuge besser akzeptieren. Über die Studienergebnisse berichtet das Team aus der Abteilung Allgemeine Psychologie von Prof. Dr. Christoph Herrmann im Fachmagazin Scientific Reports.

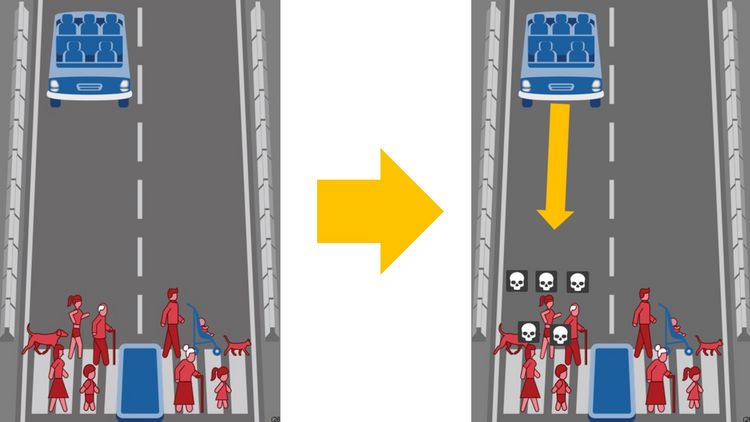

Wie sollte sich ein selbstfahrendes Auto verhalten, wenn eine Kollision entweder mit einem Kind oder einer Gruppe von Menschen unausweichlich ist? Wie verhält es sich, wenn das Leben des Autofahrers gerettet werden könnte, aber dafür ein Haustier überfahren wird? Dilemmata wie diese sind der Kern des berühmten Moral Machine-Tests, mit dem das Massachusetts Institute of Technology (USA) vor einigen Jahren die Antworten auf Fragen wie diese von Millionen von Menschen auswertete, die online an dem Test teilnahmen. Diesen Versuch haben die Oldenburger Forschenden jetzt wiederholt – mit zwei entscheidenden Anpassungen. Zum einen haben sie ihre Testpersonen nach deren Entscheidung mit der vermeintlichen Entscheidung der Künstlichen Intelligenz konfrontiert, die das Auto steuert. Zum anderen haben sie dabei die Gehirnströme ihrer Probandinnen und Probanden gemessen. „Je komplexer ein Prozess ist, desto länger dauert die Verarbeitung im Gehirn“, erklärt Maren Bertheau, Erstautorin der Studie und Doktorandin bei Herrmann. Während zum Beispiel die reine Wahrnehmung eines visuellen Reizes schon nach etwa 0,1 Sekunden in Hirnstrommessungen sichtbar wird, sorgen komplexere kognitive Prozesse wie das Wiedererkennen des Bildes erst nach etwa 0,3 Sekunden für messbare Ausschläge. Auch beim Test in der Studie war bei den Teilnehmenden nach 0,3 Sekunden ein deutlicher Ausschlag sichtbar – nach Einschätzung der Forschenden der Moment, in dem das Gehirn entschlüsselt, ob Mensch und Maschine gleich gehandelt hätten. Das Bemerkenswerte: Weicht das Handeln der Maschine ab, kommt es nach Messungen des Teams zu einer bis zu zwei Mikrovolt höheren Erregung. Diese Diskrepanz zwischen kongruenten und nicht-kongruenten Entscheidungen hält – auch während des Abflachens der Erregung – mehrere Millisekunden lang an.

„Wir suchen nach ersten Ansätzen, mit denen wir irgendwann im Alltag messen können, ob Menschen mit der Entscheidung eines selbstfahrenden Autos einverstanden sind“, erklärt Herrmann. Dabei gehe es nicht darum, perspektivisch Kraft eigener Gedanken ein Fahrzeug zu steuern, sondern darum, die Fahrweise des Autos möglichst präzise an das individuell erwünschte Verhalten anzupassen. Denkbar sei, in mittelbarer Zukunft anhand von mobil erhobenen Hirnströmen zu messen, ob ein Überholmanöver für den Fahrer zu gewagt oder die Ampel in den Augen der Fahrerin zu orange war. „So entstünde ein Fahrprofil, das immer stärker dem Komfort, dem Sicherheitsgefühl und anderen Ansprüchen der Nutzenden entspricht“, sagt Herrmann.

Gleichzeitig betonen die Forschenden die Grenzen ihrer aktuellen Studie. Ihre Ergebnisse basieren auf den gemittelten Werten von 34 Testpersonen, das heißt, dass sie übereinstimmende Aktivitäten bei einer Vielzahl von Probandinnen und Probanden beobachten konnten, die deutliche Hinweise auf die geschilderten Zusammenhänge geben. Um im Alltag anwendbar zu sein, müssten die beschriebenen Hirnaktivitäten aber bei allen Personen und jederzeit messbar sein. Ob und wie das funktioniert, muss Gegenstand weiterer Untersuchungen sein. Das gilt auch für die Frage, ob sich die Bewertung von Verkehrsentscheidungen, die weniger stark emotionalisieren als Dilemma-Situationen, ebenfalls so deutlich an Hirnströmen ablesen lässt. An diese Frage haben die Oldenburger Forschenden bereits angeknüpft und ein weiteres Experiment durchgeführt: Testpersonen mussten dabei bewerten, ob eine Lücke groß genug fürs Linksabbiegen ist. Die Ergebnisse dieser Studie sollen demnächst veröffentlicht werden.